在大數據時代,處理海量數據已成為企業運營與決策的核心需求。尤其是在互聯網技術領域,無論是用戶行為分析、日志處理,還是推薦系統優化,都需要對TB甚至PB級別的數據進行高效、準確的排序。Hadoop作為分布式計算框架的基石,為大規模數據的全局排序提供了強大的技術支持。

一、Hadoop排序的核心機制

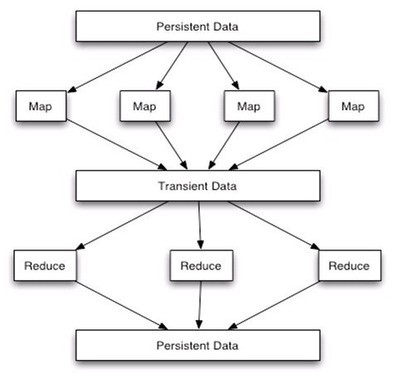

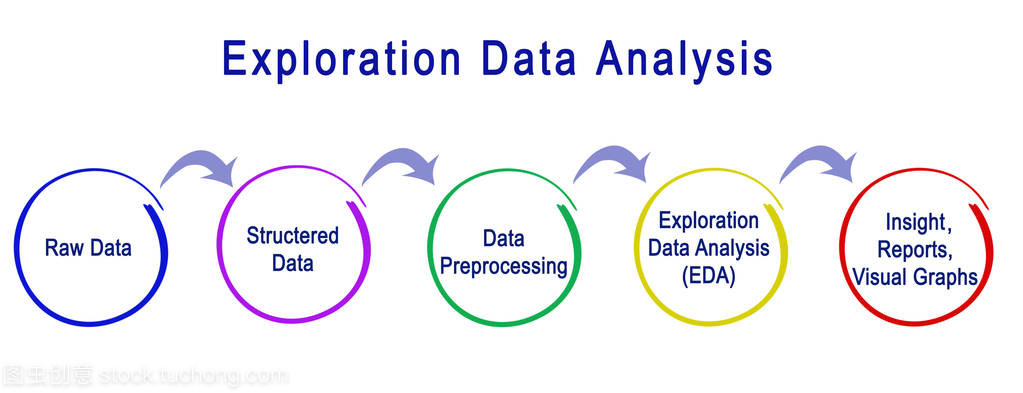

Hadoop的MapReduce編程模型天然支持排序。在Shuffle階段,Map任務輸出的中間結果會按照Key進行分區和排序,然后發送給Reduce任務。Reduce任務在接收數據時,也會對來自不同Map任務的相同Key的數據進行歸并排序。這種機制使得在單個Reduce任務中,數據是全局有序的。

要實現真正意義上的全局排序(即所有數據按照一個全局順序排列),通常需要一個Reduce任務。當數據量極大時,單Reduce任務會成為性能瓶頸。因此,實際應用中常采用“抽樣-范圍分區”的策略:

- 抽樣階段:運行一個抽樣作業,從數據集中抽取少量Key樣本。

- 生成分區文件:對樣本進行排序,并根據樣本的分布情況,計算出一個分區邊界列表,確保每個分區包含大致相等的數據量。

- 全局排序作業:在正式的排序作業中,使用

TotalOrderPartitioner,并加載上一步生成的分區文件。這樣,Map任務輸出的數據會根據Key所屬的范圍被分發到不同的Reduce任務,每個Reduce任務處理一個范圍的數據,并在內部進行排序。所有Reduce任務的輸出按分區順序拼接起來,就是全局有序的結果。

二、關鍵技術實現與優化

1. 自定義Key與Comparator

為了實現復雜排序邏輯(如二次排序),需要自定義WritableComparable的Key類,并實現compareTo方法。可能需要為Map端排序、Reduce端分組和Reduce端排序分別設置不同的Comparator。

2. 使用Combiner減少數據傳輸

在Map端使用Combiner進行本地聚合,可以顯著減少Shuffle階段需要傳輸的數據量,提升整體性能。但需注意,Combiner的操作必須是冪等的,且不影響最終結果。

3. 內存與磁盤優化

調整io.sort.mb(Map端排序緩沖區大小)、io.sort.factor(歸并因子)等參數,可以在內存使用和磁盤I/O之間找到最佳平衡點,防止作業因內存溢出而失敗。

4. 并行度調優

合理設置Reduce任務的數量至關重要。數量太少會導致單個任務負載過重,太多則會增加任務啟動和調度的開銷。通常,Reduce任務數可設置為集群中可用Reduce槽位的0.95到1.75倍。

三、在互聯網技術與電腦動畫設計中的應用

互聯網技術領域

- 用戶畫像與行為分析:對數十億用戶的點擊流、購買記錄按時間或權重排序,進行趨勢分析和用戶分群。

- 搜索引擎索引構建:對全網爬取的海量網頁數據,按PageRank、關鍵詞相關性等指標進行排序,生成倒排索引。

- 廣告點擊率(CTR)預估:對海量的廣告曝光、點擊日志按用戶、廣告位等進行排序,用于模型訓練和效果評估。

電腦動畫設計領域

隨著3D動畫、特效渲染的數據量激增,Hadoop排序也能發揮作用:

- 渲染任務調度:對成千上萬的渲染幀任務,根據復雜度、依賴關系、優先級進行全局排序,優化渲染農場的任務隊列,提高整體渲染效率。

- 資產管理與版本控制:對龐大的模型、紋理、動畫序列文件,按修改時間、文件大小或項目依賴進行排序,便于團隊協作和資產管理。

- 動作捕捉數據處理:對連續的動作捕捉數據流(如MoCap數據),按時間戳進行全局排序和清洗,為后續的動畫合成提供準備。

四、實踐注意事項

- 數據傾斜問題:如果某個Key的數據量異常龐大,會導致對應的Reduce任務執行緩慢,成為“拖后腿”的任務。需要通過更好的抽樣策略或自定義分區邏輯來緩解。

- 容錯與監控:Hadoop作業運行時間可能很長,需關注作業進度、資源使用情況,并處理好可能的失敗重試。

- 輸出格式:排序后的輸出通常選擇順序文件格式(SequenceFile),它能更好地支持大數據塊和壓縮,便于后續處理。

###

利用Hadoop進行大規模數據的全局排序,是一項將分布式計算理論付諸實踐的關鍵技術。通過深入理解MapReduce的排序機制,并結合巧妙的抽樣分區策略,我們能夠高效地駕馭海量數據,為互聯網服務和數字內容創作(如電腦動畫設計)提供深度的數據洞察和強大的處理能力。隨著計算框架的演進(如Spark在某些場景下提供了更優的排序性能),其核心思想——分而治之、抽樣與范圍分區——依然是處理超大規模數據排序的寶貴財富。